小觅双目深度相机开源vSLAM算法用于无人驾驶

2016年以来,无人驾驶创业公司不断涌现,如今正面临着商业化探索的关键时期。接下来,无人驾驶的行驶方式等待检验、量产中亦有诸多难题等待解决。前不久,李开复还曾公开表示,像Waymo一样的自动驾驶,即人可以不在驾驶位上,还需要很久,但是以后的车没法人机协作。

他还进一步解释道:“我们也可以认为以后无人驾驶达到了一定的程度,它就会通过物联网彼此交流,比如说一辆车可以告诉另外一辆车,说我爆胎了,请你们让开一点。自动驾驶将取代人类驾驶。当然达到这个程度还有20年,30年还是40年,有争议存在。”

虽然在商业落地的过程中,无人驾驶的生态圈还面临众多难点。但大多数人依然支持“自动驾驶是人工智能改变世界的光辉起点”的这一观点,对该领域的探索也不会止步。这其中,SLAM的应用至关重要。

SLAM(同步定位与地图构建),是指运动物体根据传感器的信息,一边计算自身位置,一边构建环境地图的过程,解决机器人等在未知环境下运动时的定位与地图构建问题。目前,SLAM在无人驾驶领域的用途包括传感器自身的定位,以及后续的路径规划、运动性能、场景理解等。

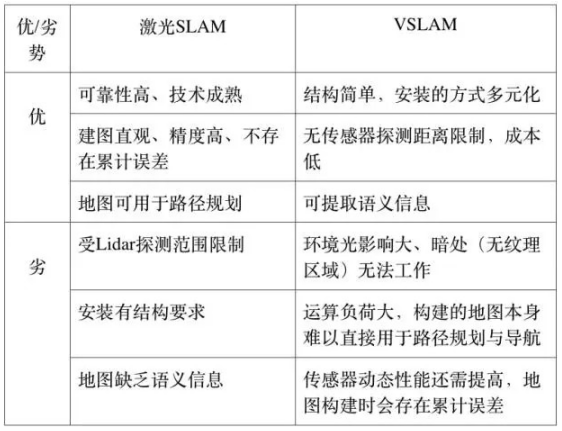

由于传感器种类和安装方式的不同,SLAM 的实现方式和难度会有一定的差异。按传感器来分,SLAM 主要分为激光 SLAM 和 vSLAM 两大类。早在 2005 年的时候,激光 SLAM 就已经被研究的比较透彻,直到目前,激光 SLAM仍然是最稳定、最主流的定位导航方法。

随着计算机视觉的迅速发展,vSLAM(基于视觉的定位与建图)因为信息量大,适用范围广等优点逐渐受到广泛关注。基于视觉的 SLAM 方案目前主要有两种实现路径,一种是基于 RGBD 的深度摄像机,比如英特尔的Realsense和小觅深度相机系列产品;还有一种就是基于单目、双目或者鱼眼摄像头的。

基于深度相机的 SLAM ,跟激光 SLAM 类似,通过收集到的点云数据,能直接计算障碍物距离,相比基于单目、鱼眼相机的 vSLAM 方案,需要利用多帧图像来估计自身的位姿变化,再通过累计位姿变化来计算距离物体的距离,并进行定位与地图构建,基于深度相机的 SLAM 方案在无人驾驶领域应用更为普遍。

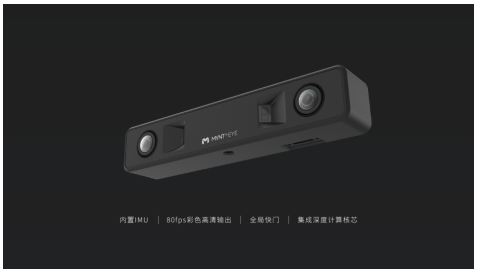

小觅双目摄像头深度版(MYNT EYE Depth)采用“视觉+结构光+惯性导航”融合的方案,内置深度计算芯片,无需上位机即可输出深度。相较固态激光、单目相机、视觉相机、结构光相机和ToF相机等单一深度传感器方案,“视觉+结构光+惯性导航”融合的方案是适用场景更广泛且更具性价比的3D传感器融合解决方案。

小觅双目摄像头深度版提供120°FOV和50°FOV两种视角方案给客户选择,120°FOV版本提供更广阔的深度识别范围,50°FOV版本则具备更高精度水平和识别深度,识别距离可达15m,精度可达毫米级,为室外作业环境提供了更多可能。

总的来说,想让用户在AR/VR、机器人、无人机、无人驾驶领域体验加强,还是需要更多SLAM前沿技术做支持。未来新型传感器的出现也会不停地为SLAM注入活力,在降低SLAM算法难度的同时,也会给SLAM的技术格局带来许多变化。

图片新闻

最新活动更多

-

6月13日立即参评>> 【评选】维科杯·OFweek2025中国工业自动化及数字化行业年度评选

-

6月13日立即参评>> 【评选启动】维科杯·OFweek(第四届)2025汽车行业年度评选

-

6月13日立即参评 >> 【评选启动】维科杯·OFweek 2025(第十届)人工智能行业年度评选

-

7.30-8.1火热报名中>> 全数会2025(第六届)机器人及智能工厂展

-

7月31日免费预约>> OFweek 2025具身机器人动力电池技术应用大会

-

即日-2025.8.1立即下载>> 《2024智能制造产业高端化、智能化、绿色化发展蓝皮书》

推荐专题

- 1 【独家深度】2025年中国机器人激光雷达行业市场调研

- 2 人形机器人革命,NVIDIA如何破局?

- 3 《2025机器人+应用与产业链新一轮加速发展蓝皮书》电子版限免下载!

- 4 用信步工控主板,当行业冠军,“天工”机器人马拉松夺冠!

- 5 【展商推荐】意优科技:专注于人形机器人关节模组的研发与生产

- 6 信步科技发布具身智能开发平台HB03,实现机器人“大、小脑融合”

- 7 MOONLIGHT 玄晖成为全球首款获得 CE+ETL双认证的力控型并联机器人

- 8 MiR 发布最新电子书,揭示AMR 革新医院物流全流程

- 9 谁将成为行业榜样?维科杯·OFweek2025中国工业自动化及数字化行业年度评选邀您参与!

- 10 【展商推荐】因时机器人:专注于微型精密运动部件研发制造和伺服控制技术突破创新

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论