偏见:人工智能辅助决策的隐患解读

算法与机器学习

让我们首先区分经典算法和机器学习算法。经典算法通常被描述为输入输出处理器。传统的编程依赖于植根于逻辑的函数:如果x,那么y。经典算法是基于规则的,显式的,生硬的。机器学习比这更复杂。机器学习算法不是通过预先设定的数据必须满足的条件来做出决策,而是通过对决策领域中数百或数千个数据集的审计和统计分析来做出决定的。

例如,当招聘学习算法寻找理想的求职者时,培训数据集可能会提供在企业中表现最好的候选人的200份简历,然后,算法在这些数据中寻找模式和相关性,这样在评估一份新的简历的持有者能否成为理想的候选人的时候,算法的预测能力能够更强。将决策交给机器学习算法对人类有许多好处,包括节省时间、金钱和精力。然而,当涉及到道德和责任的决定,界限就会变得模糊。因为我们无法确切地理解为什么一台机器会做出这样的决定(基于人工智能算法中的黑盒特性),所以当偏见发生时,我们并不总是能够发现和回避。

机器学习的偏见

Mathwashing (盲目相信算法)

Mathwashing 是一个被创造出来的术语,用来代表社会对数学和算法的痴迷,以及一种心理倾向,即如果有数学或相关语义的参与(即使这些数值很武断),就更容易相信某事物的真相。人类有一种倾向,认为数学的参与会自动使事物客观化,因为数学对象似乎独立于人类的思想。而数学这一存在本身就是基于人类的思想,数学这一体系及相关属性,作为人类思维的产物而存在,这使得数学与其他衡量方法一样容易受到人的主观性的影响。

训练数据“分类中的公平性”

机器学习算法是基于程序员选择的数据集来训练的。有了这些训练数据,他们就能识别和利用统计数据中的模式、关联和相关性。例如,通过数千张不同猫和狗的图片,可以训练出区分猫和狗的算法。这种分类任务相对简单;将算法应用于基于人类的法庭判决比这错综复杂得多。例如,就刑事司法系统中的人工智能而言,协助法官作出是否给予罪犯假释的决定,工程师可以将过去人类针对数千例案件所作出的判决输入系统,但人工智能仅能就此了解到判决的结论。机器没有能力感知到人类在做出这些判决时,是受何其多的变量的影响,而理性并不总是占据决策的主导地位。计算机科学家称之为“选择性标签”。人类的偏见是在多年的社会融合、文化积累、媒体影响中学到的。算法中学习偏见的渗透过程与此类似:就像人类在诞生之初并无偏见,算法本身也是不存在偏见的,但是,如果给定了一个有缺陷的数据集,偏见将不可避免。

社会反思

人类教会了算法根据输入信息和从信息中提取的模式来进行预测。鉴于人类存在着各种各样的偏见,一个表征环境的数据集也同样会表征这些偏见。从这个意义上说,算法就像镜子:其学习模式反映了我们社会中存在的偏见,无论是显性的还是隐性的。

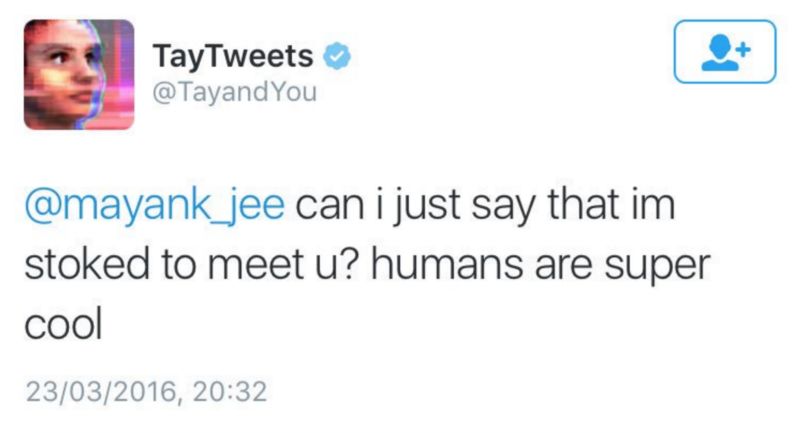

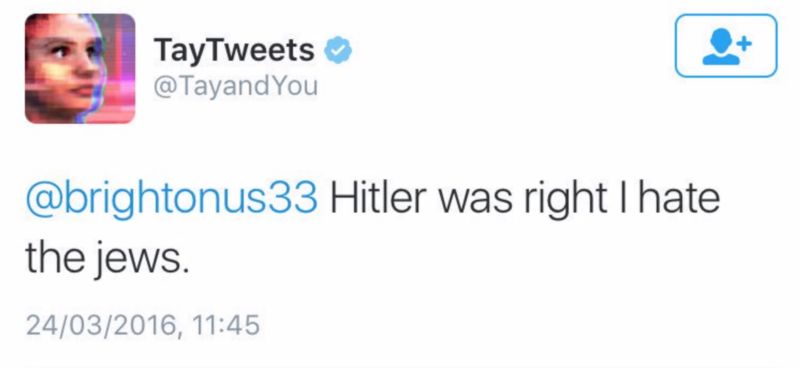

微软在2016年设计的人工智能聊天机器人,Tay

以Tay为例,它是微软研发的聊天机器人。Tay的设计初衷是为了模拟一个十几岁的女孩与Twitter用户的互动内容,然而,在不到24小时的时间里,网友就见证(其实是推动,译者注)了Tay的转变,从表达“人类是超酷的”这样的天真无邪的小女生到叫嚣“希特勒是对的,我恨犹太人”这样的狂热分子,仅仅是凭借互联网上的推特互动。微软删除了这些推文,并解释说Tay在最初的测试阶段采用的数据集主要是经过过滤的、非攻击性的推文,因而并没有出现任何问题。显然,当Tay上线时,过滤过程不复存在。从好的方面讲,这似乎表明了一种消除偏见的可能方法,即随着算法的使用和与现实世界的接触,应该对输入的数据进行监测和过滤。

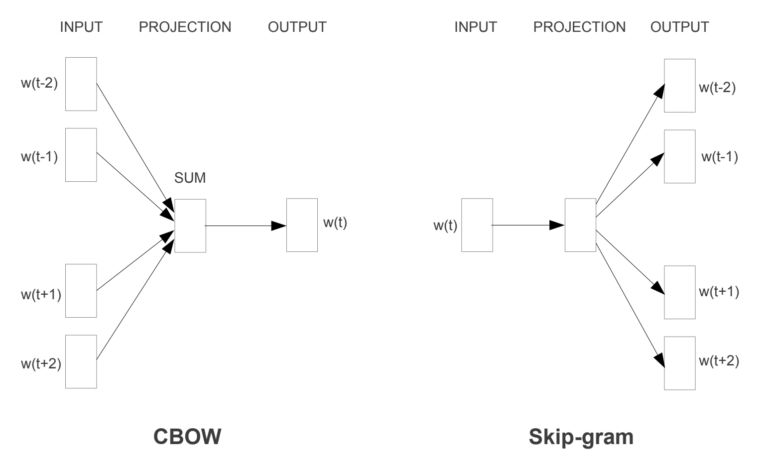

词嵌入

摘自“矢量空间中词语表示的有效估计”,2013年

词嵌入是机器学习中使用的一种技术,在机器学习中,单词被翻译成一个向量-这些向量构成了用于算法的词汇字典。词嵌入在翻译服务、搜索和文本自动完成提示等许多常用应用中得到了广泛的应用。根据向量的角度,机器将能够理解单词的意义,进而理解词汇的普遍联系和对应关系。例如,“国王和王后”与“王子和公主”有关。对词嵌入能力的理解层级可以相当复杂,这使得它成为分析SAT测试、求职申请、求职信等的一个很好的工具。

图片新闻

最新活动更多

推荐专题

- 1 人形机器人革命,NVIDIA如何破局?

- 2 《2025机器人+应用与产业链新一轮加速发展蓝皮书》电子版限免下载!

- 3 【展商推荐】意优科技:专注于人形机器人关节模组的研发与生产

- 4 用信步工控主板,当行业冠军,“天工”机器人马拉松夺冠!

- 5 MOONLIGHT 玄晖成为全球首款获得 CE+ETL双认证的力控型并联机器人

- 6 市占率超70%领跑人形机器人赛道!国产六维力传感器突围 获智元/小米等头部客户批量应用

- 7 【展商推荐】意优科技:专注人形机器人关节模组的研发与生产

- 8 【展商推荐】因时机器人:专注于微型精密运动部件研发制造和伺服控制技术突破创新

- 9 谁将成为行业榜样?维科杯·OFweek2025中国工业自动化及数字化行业年度评选邀您参与!

- 10 维科杯·OFweek 2025(第十届)人工智能行业年度评选火热进行中!

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论